作者|刘大一恒、齐炜祯、晏宇、宫叶云、段楠、周明

编者按:微软亚洲研究院提出新的预训练模型ProphetNet,提出了一种新的自监督学习目标——同时预测多个未来字符,在序列到序列的多个自然语言生成任务都取得了优异性能。

大规模预训练语言模型在自然语言理解和自然语言生成中都取得了突破性成果。这些模型通常使用特殊的自监督学习目标先在大规模无标记语料中进行预训练,然后在下游任务上微调。

传统自回归语言模型通过估计文本语料概率分布被广泛用于文本建模,序列到序列的建模,以及预训练语言模型中。这类模型通常使用teacher-forcing的方法训练,即每一时刻通过给定之前时刻的所有字符以预测下一个时刻的字符。然而,这种方式可能会让模型偏向于依赖最近的字符,而非通过捕捉长依赖的信息去预测下一个字符。有如以下原因:局部的关系,如两元字符的组合,往往比长依赖更强烈;Teacher-forcing每一时刻只考虑对下一个字符的预测,并未显式地让模型学习对其他未来字符的建模和规划。最终可能导致模型对局部字符组合的学习过拟合,而对全局的一致性和长依赖欠拟合。尤其是当模型通过贪心解码的方式生成序列时,序列往往倾向于维持局部的一致性而忽略有意义的全局结构。

多链统一交易基础设施zkLink推出新忠诚度积分系统:8月20日消息,多链统一交易基础设施zkLink宣布推出新的忠诚度积分系统。忠诚度积分作为参与生态系统的证明,可用于获得未来的奖励和独家福利;用户在与zkLink生态系统DApp互动、执行链上任务、在社交媒体上互动以及积极参与社区活动都可以获得忠诚度积分。

zkLink强调,其正在从过去的活动中收集数据,包括旧忠诚度积分(Loyalty Points)、Loyalty NFT、Zealy Points、Weekly quizes OATs、Sograph OAT、Dunkirk OAT on Galxe、Dunkirk OAT on Aki Network、Community Calls and AMA OATs以及其他小规模活动的积分。

zkLink将于2023年第四季度向Galxe上的这些用户收集、上传和空投积分。[2023/8/21 18:11:59]

ProphetNet

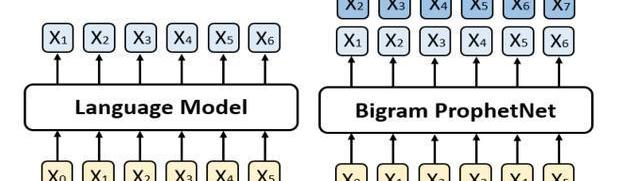

针对上述问题,我们提出了一个新的seq2seq预训练模型,我们称之为ProphetNet。该模型带有一个新颖的自监督学习目标函数,即预测未来的N元组。与传统seq2seq的Teacher-forcing每一时刻只预测下一个字符不同,ProphetNet每一时刻将学习去同时预测未来的N个字符。如图1所示:

比特币全网未确认交易数量为8053笔:金色财经报道,BTC.com数据显示,目前比特币全网未确认交易数量为8053笔,全网算力为347 EH/s,24小时交易速率为4.18交易/s,目前全网难度为48.71 T,预测下次难度下调0.14%至48.64 T,距离调整还剩11天20小时。[2023/4/23 14:20:44]

图1:左边是传统的语言模型,每一时刻预测下一时刻的字符。右边是Bigram形式下的ProphetNet,每一时刻同时预测未来的两个字符。

预测未来N元组这一自监督学习目标在训练过程中显式地鼓励模型在预测下一个字符时考虑未来更远的字符,做到对未来字符的规划,以防止模型对强局部相关过拟合。

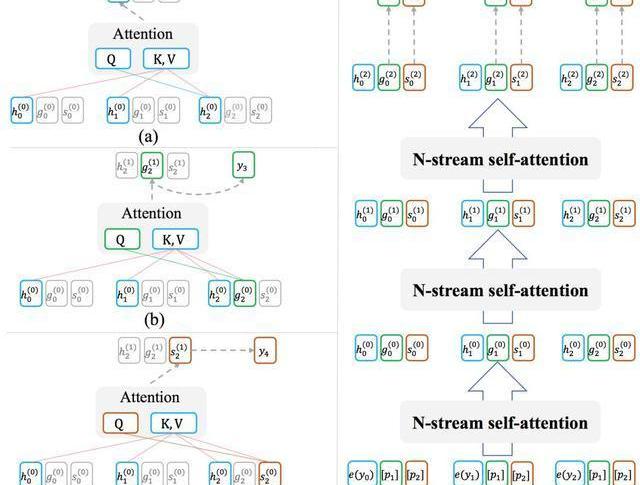

ProphetNet基于Transformer的seq2seq架构,其设计有两个目标:1.模型能够以高效的方式在训练过程中完成每时刻同时预测未来的N个字符;2.模型可以灵活地转换为传统的seq2seq架构,以在推理或微调阶段兼容现有的方法和任务。为此,我们受XLNet中Two-streamselfattention的启发,提出了用于模型decoder端的N-streamself-attention机制。图2展示了bigram形式下的N-streamself-attention样例。

PeckShield:0xA69F8 开头地址过去 12 小时盗取了 153 枚 NFT:金色财经报道,据PeckShield监测,0xA69F8开头地址过去12小时盗取了153枚NFT,包括4枚Digidaigaku系列和6枚DigiDaigakuHeroes系列NFT,其中DigiDaigaku#756和DigiDaigaku#1407已在X2Y2上以9.3ETH和8.2ETH的价格被出售。[2023/2/13 12:04:03]

除了原始的multi-headself-attention之外,N-streamself-attention包含了额外的N个predictingstreamself-attention,用于分别预测第n个未来时刻的字符所示。每一个predictingstream与mainstream共享参数,我们可以随时关闭predictingstream以让模型转换回传统seq2seq的模式。

游戏平台GameSwift与Polygon合作构建“去中心化版Steam”链游工具:金色财经报道,游戏平台GameSwift宣布与Polygon达成合作,双方将为开发者和游戏工作室构建“去中心化版Steam”链游工具,旨在推动 Web2 游戏融合到 Web3 环境中。GameSwift 前身为 StarTerra,目前正在扩展其功能以为 Web3 游戏项目提供成熟的网络,与 Polygon 的合作将使其建立基于 Polygon Edge 框架的游戏链。(globenewswire)[2022/8/24 12:44:35]

图2:(a)为mainstreamself-attention;(b)为1-stpredictingstreamself-attention;(c)为2-ndpredictingstreamself-attention;(d)展示了n-streamself-attention的输入输出及流程。

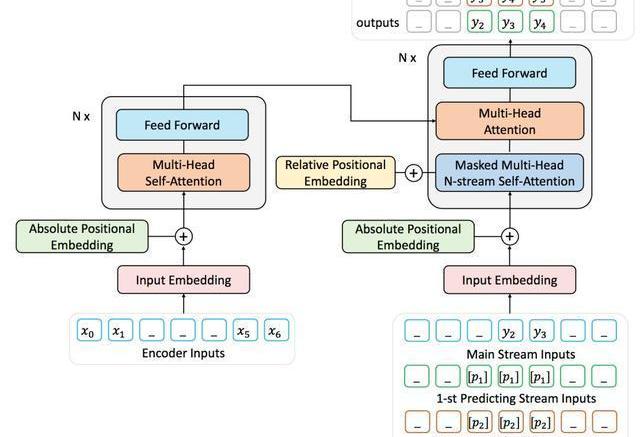

由于难以获取到大量带标记的序列对数据,我们用去噪的自编码任务通过大量无标记文本预训练ProphetNet。去噪的自编码任务旨在输入被噪音函数破坏后的序列,让模型学习去复原原始序列。该任务被广泛应于seq2seq模型的预训练中,如MASS、BART、T5等。本文中使用MASS的预训练方式,通过引入提出的predictingn-stream自监督学习目标函数预训练ProphetNet。我们以bigram形式的ProphetNet为例,整个流程如图3所示:

NEXO回应挪用慈善基金建豪宅:虚假指控,将诉诸法律诉讼:6月27日消息,加密借贷平台 NEXO 在其官网回应“挪用慈善基金建豪宅”的指控为假消息。爆料者 @otteroooo 意在通过此类新闻增加其粉丝数,并转卖账号用以变现。

NEXO 表示,所谓爆料推文中存在引用信息不实、信源不权威,甚至错将第三方指认为 Nexo 联合创始人的低级错误。Nexo 将以最严肃的态度对待所有客户,并为保护他们及其资产,使用任何合法可用的手段。Nexo 的美国和英国法律顾问正在针对推特上的诽谤性陈述和虚假指控提起法律诉讼。[2022/6/27 1:33:40]

图3:二元形式下的Prophet整体框架图

实验结果

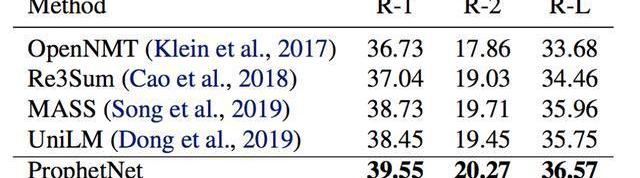

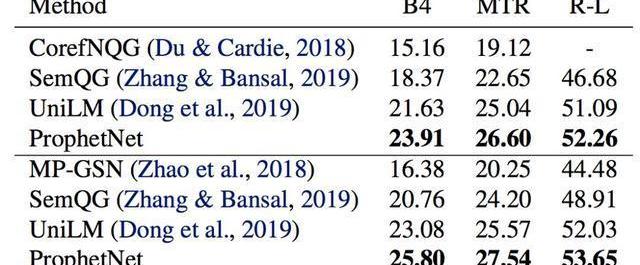

我们使用两个规模的语料数据训练ProphetNet。ProphetNet包含12层的encoder和12层的decoder,隐层大小为1024。先在BERT所使用的BookCorpus+Wikipedia的数据上预训练模型,将模型在Textsummarization和Questiongeneration两个NLG任务上的三个数据集微调并评估模型性能。与使用同等规模数据的预训练模型相比,ProphetNet在CNN/DailyMail、Gigaword和SQuAD1.1questiongeneration数据集上都取得了最高的性能,如表1-3所示。

表1:CNN/DailyMail测试集结果

表2:Gigaword测试集结果

表3:SQuAD1.1测试集结果SQuAD1.1交换验证测试集结果

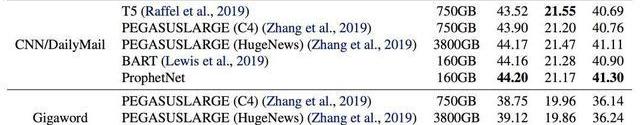

除了使用16GB的语料训练模型,我们也进行了更大规模的预训练实验。该实验中,我们使用了160GB的语料预训练ProphetNet。我们展示了预训练14个epoch后的ProphetNet在CNN/DailyMail和Gigaword两个任务上微调和测试的结果。如表4所示。需要注意的是,在相同大小的训练数据下,我们模型的预训练epoch仅约为BART的三分之一。我们模型的训练数据使用量仅约为T5和PEGASUSLARGE的五分之一,约为PEGASUSLARGE的二十分之一。尽管如此,我们的模型仍然在CNN/DailyMail上取得了最高的ROUGE-1和ROUGE-LF1scores。并在Gigaword上实现了新的state-of-the-art性能。

表4:模型经大规模语料预训练后在CNN/DailyMail和Gigaword测试集的结果

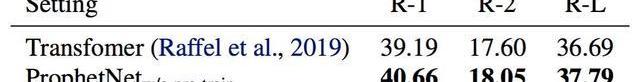

为了进一步探索ProphetNet的性能,我们在不预训练的情况下比较了ProphetNet和Transformer在CNN/DailyMail上的性能。实验结果如表5所示,ProphetNet在该任务上超越了同等参数量的Transformer。

表5:模型不经过预训练在CNN/DailyMail验证集结果

总结

本文介绍了微软亚洲研究院在序列到序列模型预训练的一个工作:ProphetNet,该模型提出了一种新的自监督学习目标,在同一时刻同时预测多个未来字符。并通过提出的N-streamself-attention机制高效地实现了模型在该目标下的训练。实验表明,该模型在序列到序列的多个自然语言生成任务都取得了不错的性能。我们将在之后尝试使用更大规模的模型架构和语料进行预训练,并进一步深入地探索该机制。

论文链接:https://arxiv.org/pdf/2001.04063.pdf

原力计划

《原力计划-学习力挑战》正式开始!即日起至3月21日,千万流量支持原创作者!更有专属等你来挑战

Python数据清理终极指南口罩检测识别率惊人,这个Python项目开源了谈论新型冠状病、比特币、苹果公司……沃伦巴菲特受访中的18个金句,值得一看!天猫超市回应大数据杀熟;华为MateXs被热炒至6万元;Elasticsearch7.6.1发布一张图对比阿里、腾讯复工的区别不看就亏系列!这里有完整的Hadoop集群搭建教程,和最易懂的Hadoop概念!|附代码

在全球经济和健康危机中,比特币SV(BSV)表现良好。按市值计为全球第五大加密货币的BSV较上年同期上涨90%,且刚刚经历了一次预编程的区块奖励减半,并通过维持关键技术支撑位来维持中期看多倾向.

1900/1/1 0:00:00见习记者丨邹璐徽 疫情蔓延,油价暴跌,美股罕见触发熔断机制……全球金融市场巨震不断之下,市场避险情绪也在持续升温.

1900/1/1 0:00:00锁定期间有很多时间可供使用,我们当中许多人都接受了扩大视野的想法。学习外语是显而易见的选择。我个人会赞同这一点:我的个人情况使得到12岁时我会说德语,希腊语和英语,因此语言成为我的激情和爱好.

1900/1/1 0:00:00400年前,印第安人生活在这片水草茂盛、动植物资源丰富的美洲大陆上,这片土地上有着数量极其庞大的野牛,他们以牛肉为食、牛皮为衣,过着衣食无忧的生活!在广袤的草原上时而与猛兽周旋.

1900/1/1 0:00:00大家好!炉石传说新版本外域的灰烬给除了恶魔猎手外的九大职业都推出了一张终极随从。两个周的时间过去了,两个平衡补丁上线,三次天梯环境变化,这九张终极随从到底表现如何,是否当得起“终极”这个名号呢?.

1900/1/1 0:00:00在发现澳大利亚黑天鹅之前,所有的欧洲人都确信天鹅全部是白色的。因为它似乎已经被人们的经验证明是一个真理。但当黑天鹅第一次被欧洲人所发现,这个真理就被事实所打破.

1900/1/1 0:00:00