来源:量子位

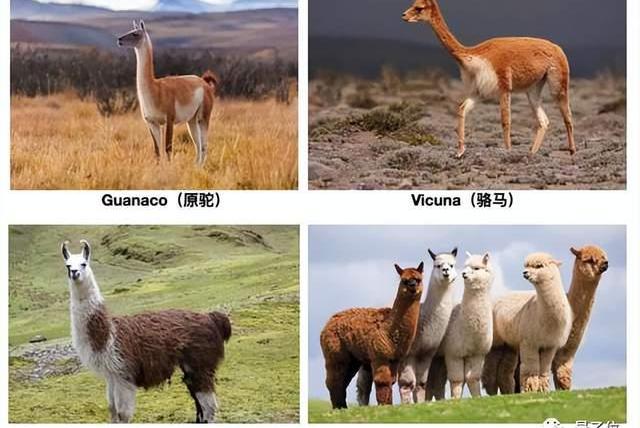

从Meta的LLaMA发展出的羊驼家族一系列大模型,已成为开源AI重要力量。

但LLamA开源了又没全开,只能用于研究用途,还得填申请表格等,也一直被业界诟病。

好消息是,两大对标LLaMA的完全开源项目同时有了新进展。

可商用开源大模型来了,还一下来了俩:

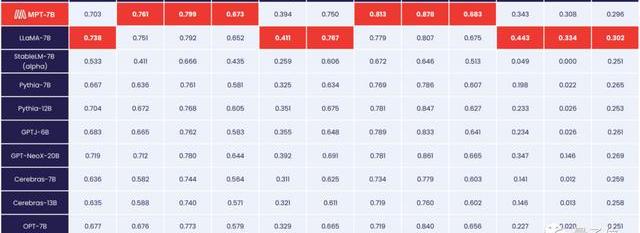

MosaicML推出MPT系列模型,其中70亿参数版在性能测试中与LLaMA打个平手。

Together的RedPajama系列模型,30亿参数版在RTX2070游戏显卡上就能跑。

Neopets CEO:市场状况和社区对加密的负面情绪是取消加密游戏的两大原因:金色财经报道,Neopets Metaverse 是一款由NFT驱动的游戏,基于1999年广受欢迎的宠物模拟器,开发了大约两年后在上个月突然被取消,该团队正在将Neopets Metaverse的一些资产重新用于一款新的手机游戏,该游戏将不包含任何加密元素。Neopets首席执行官 Dominic Law对此解释称,市场状况和社区对加密货币的负面情绪是 Neopets 取消其加密游戏的两大原因。他说:“在这个阶段,他们可能不太关心 Web3 是什么,这对大众市场有很多负面影响。”

Dominic Law表示,发布更高质量的 NFT 游戏可以帮助减少目前围绕该行业的误解。然而,截至目前,他认为市场上没有足够的好产品。[2023/8/8 21:30:55]

对于这些进展,特斯拉前AI主管AndrejKarpathy认为,开源大模型生态有了寒武纪大爆发的早期迹象。

声音 | 农业银行研发中心赵韵东:跨链的信息孤岛和隐私保护两大问题仍待解决:金色财经报道,中国农业银行研发中心副总经理赵韵东在采访时表示,银行对于新技术的应用很积极,也乐于尝试。但是大规模的使用和推广则是相对谨慎的。区块链技术的发展仍处于爬坡阶段,尚不完全成熟,很多应用也是在持续探索中。银行应用新技术要从三个方面着眼,第一是技术的价值,是否能够实现降本增效,扩大客户群体和提升服务能力,第二是技术和金融场景的匹配程度,第三是技术本身的成熟度。尽管区块链技术在银行业的应用初步达成了共识,但是跨链的信息孤岛和隐私保护两大问题却仍待解决。[2019/11/9]

MPT,与LLaMA五五开

MPT系列模型,全称MosaicMLPretrainedTransformer,基础版本为70亿参数。

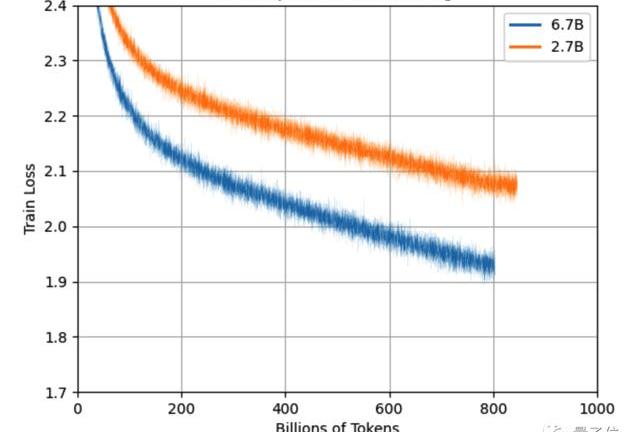

MPT在大量数据上训练,与LLaMA相当,高于StableLM,Pythia等其他开源模型。

支持84ktokens超长输入,并用FlashAttention和FasterTransformer方法针对训练和推理速度做过优化。

声音 | Genesis首席执行官:机构资金涌入加密领域尚有两大障碍需要消除:Genesis首席执行官Michael Moro近期接受采访时表示,虽然他相信机构资金将大量涌入加密领域,但仍有一些障碍需要消除。这些障碍包括监管缺乏明确性,以及与传统资产争夺同一投资者资金池的挑战。此外,他还表示,加密交易仍然需要更加规范。金融机构“在思想上很难理解这个想法”。但随着Square、富达(Fidelity)和Facebook等公司开始推出产品,加密交易将变得更易被接受,而不再像以前那样神秘和陌生。”Moro还提出,虽然数字货币是一种新的资产类别,但和传统资产一样,“都在追逐同样的投资者资金池。”他解释称:“加密领域试图吸引的资金池其实就是来自那些投资投资股票、债券和黄金等传统资产的捐赠基金、对冲基金和家族办公室,正因为如此,我总觉得加密技术的投资者想要的是与其他市场相同的产品和服务。所以这里还有一个巨大的空白需要填补。”(Seeking Alpha)[2019/10/17]

在各类性能评估中,与原版LLaMA不相上下。

声音 | 李林:区块链最大挑战是法律 STO、稳定币是未来1年两大看点:近日,火币集团CEO李林在清华大学经管学院区块链课程上表示,区块链面临最大的挑战是法律,如果没有最高法的解释,区块链的存在是没有价值的。在接下来的一年,主要看点是证券化Token以及稳定币的发展,这两件事都会对这个行业带来巨大变革。一个是资产端,证券化Token带来越来越多优质资产上链;一个是资金端,全球资金如何通过美元稳定币方式进入全球价值网络。资产端代表更多流动资产进来,资金端代表更灵活全球资金进入这个市场,都是革命性的。[2018/11/8]

除了MPT-7BBase基础模型外还有三个变体。

MPT-7B-Instruct,用于遵循简短指令。

嘉御基金卫哲:资本市场存在两大泡沫 我完全不看好ICO和比特币:从2011年嘉御基金成立之后,卫哲一直以投资人的身份出现。在近日的采访中,卫哲也表达了关于投资和区块链等热门技术的看法。他表示,商业的本质上是有一个产品/项目给公开市场,国内有专门的监管部门,国外有分析师把控项目质量,ICO不管用什么技术,请问它将用什么技术评估项目质量,所有ICO无法解决项目的质量判断,这也会造成企业和投资人之间巨大不对称。在这种情况下,99.99%的ICO项目都是不成立的。我完全不看好。[2018/3/13]

MPT-7B-Chat,用于多轮聊天对话。

MPT-7B-StoryWriter-65k+,用于阅读和编写故事,支持65ktokens的超长上下文,用小说数据集微调。

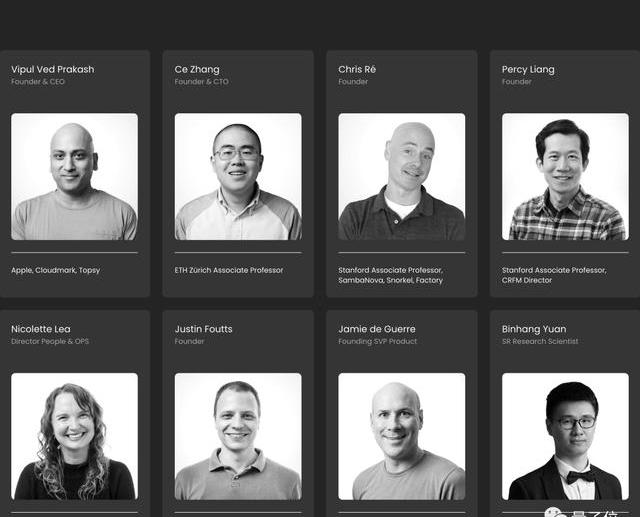

MosaicML由前英特尔AI芯片项目Nervana负责人NaveenRao创办。

该公司致力于降低训练神经网络的成本,推出的文本和图像生成推理服务成本只有OpenAI的1/15。

RedPajama,2070就能跑

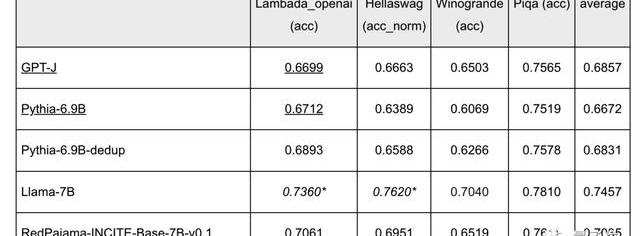

RedPajama系列模型,在5TB的同名开源数据上训练而来。

除70亿参数基础模型外,还有一个30亿参数版本,可以在5年前发售的RTX2070游戏显卡上运行。

目前70亿版本完成了80%的训练,效果已经超过了同规模的Pythia等开源模型,略逊于LLamA。

预计在完成1Ttokens的训练后还能继续改进。

背后公司Together,由苹果前高管VipulVedPrakash,斯坦福大模型研究中心主任PercyLiang,苏黎世联邦理工大学助理教授张策等人联合创办。

开源模型发布后,他们的近期目标是继续扩展开源RedPajama数据集到两倍规模。

OneMoreThing

来自南美洲的无峰驼类动物一共4种,已被各家大模型用完了。

Meta发布LLaMA之后,斯坦福用了Alpaca,伯克利等单位用了Alpaca,JosephCheung等开发者团队用了Guanaco。

以至于后来者已经卷到了其他相近动物,比如IBM的单峰骆驼Dromedary,Databricks的Dolly来自克隆羊多莉。

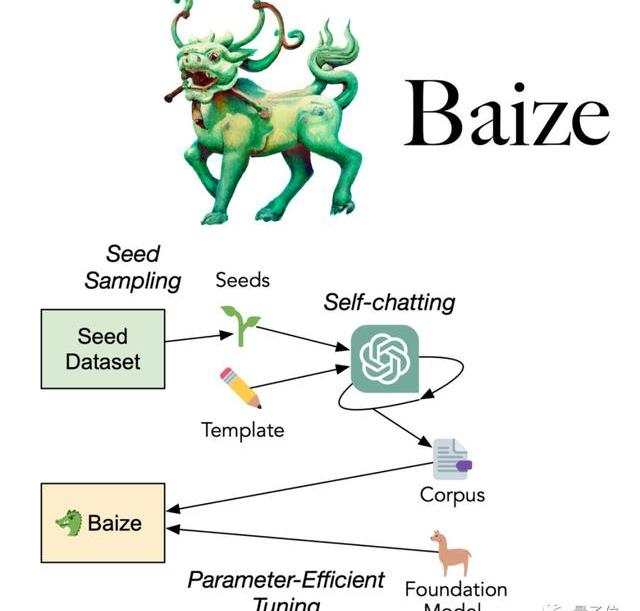

国人研究团队也热衷于用古代传说中的神兽,如UCSD联合中山大学等推出的白泽。

港中文等推出的凤凰……

最绝的是哈工大基于中文医学知识的LLaMA微调模型,命名为华驼。

参考链接:

https://www.mosaicml.com/blog/mpt-7b

https://www.together.xyz/blog/redpajama-models-v1

https://twitter.com/karpathy/status/1654892810590650376?s=20

近日网传的一份《全国法院金融审判工作会议纪要》,虽然目前官方还没有明确发布该纪要,但从体例、内容、形式等方面来讲,中本律认为比较真实,故在第一时间进行了解读,如果后续官方发布的内容有调整.

1900/1/1 0:00:00作者:@於方仁@CarolineSun编排:@黑羽小斗LLM大型语言模型是利用海量的文本数据进行训练海量的模型参数.

1900/1/1 0:00:00博链财经BroadChain获悉,4月29日,Bankless创始人DavidHoffman宣布规模为3500万美元的BanklessVentures已获得75%的承诺投资.

1900/1/1 0:00:00UBS上个月将元宇宙加入了其长期投资清单。UBS是瑞士最大、最重要的银行,成立于1998年,由瑞士银行联盟和瑞士银行公司合并而成。但它的根源可以追溯到1862年温特图尔银行成立之时.

1900/1/1 0:00:00来源:Wind香港万得通讯社报道,周六,成千上万的人聚集在内布拉斯加州奥马哈的CHI健康中心,参加伯克希尔哈撒韦公司的年度会议.

1900/1/1 0:00:00喜马拉雅山脉山脚下的不丹,曾被称为“世界上最快乐的国度”,但不断扩大的贸易赤字和不断上升的进口成本之下,这个现实秘境的香巴拉正拉响经济“警报”.

1900/1/1 0:00:00