文章速览01/LLM02/ChatGPTPrompt03/组合Agent04/Prompt微调05/总结06/参考文献LLM

大型语言模型是利用海量的文本数据进行训练海量的模型参数。大语言模型的使用,大体可以分为两个方向:

A.仅使用

B.微调后使用

仅使用又称Zero-shot,因为大语言模型具备大量通用的语料信息,量变可以产生质变。即使Zero-shot也许没得到用户想要的结果,但加上合适的prompt则可以进一步获取想要的知识。该基础目前被总结为promptlearning。

大语言模型,比较流行的就是BERT和GPT。从生态上讲BERT与GPT最大的区别就是前者模型开源,后者只开源了调用API,也就是目前的ChatGPT。

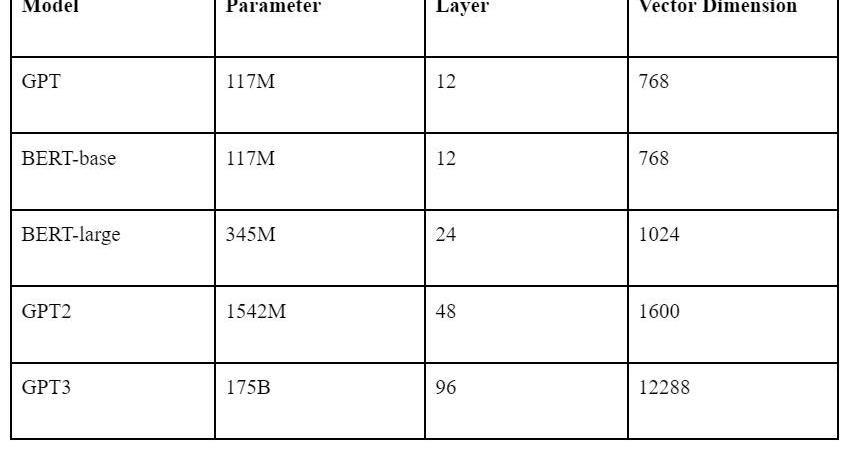

两个模型均是由若干层的Transformer组成,参数数量等信息如下表所示。

目前生态上讲,BERT多用于微调场景。因为微调必须在开源模型的基础上,GPT仅开源到GPT2的系列。且相同模型参数量下BERT在特定场景的效果往往高于GPT,微调需要调整全部的模型参数,所以从性价比而言,BERT比GPT更适合微调。

而GPT目前拥有ChatGPT这种面向广大人民群众的应用,使用简单。API的调用也尤其方便。所以若是仅使用LLM,则ChatGPT显然更有优势。

ChatGPTPrompt

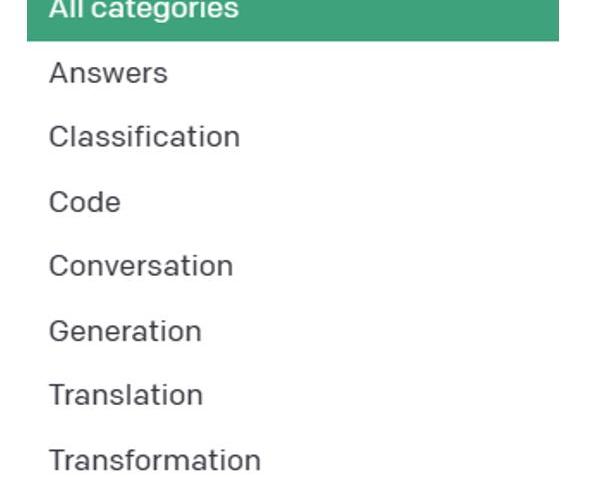

下图是OpenAI官方提出对于ChatGPT的prompt用法大类。

桑坦德银行:闪电网络每秒可处理超过100万笔交易:金色财经报道,桑坦德银行的报告估计,闪电网络每秒可处理超过100万笔交易,而VISA等传统卡支付网络每秒可处理2万笔交易。Amboss首席执行官Jesse Shrader表示,MicroStrategy和Santander等公司正在认识到基于该技术的闪电技术的潜力,而不是出于合规目的而采用它。

金色财经此前报道,桑坦德银行Santander的资产服务部门CACEIS,已在法国监管机构注册,提供加密货币托管服务。[2023/6/27 22:03:03]

Figure1.PromptCategoriesbyOpenAI?

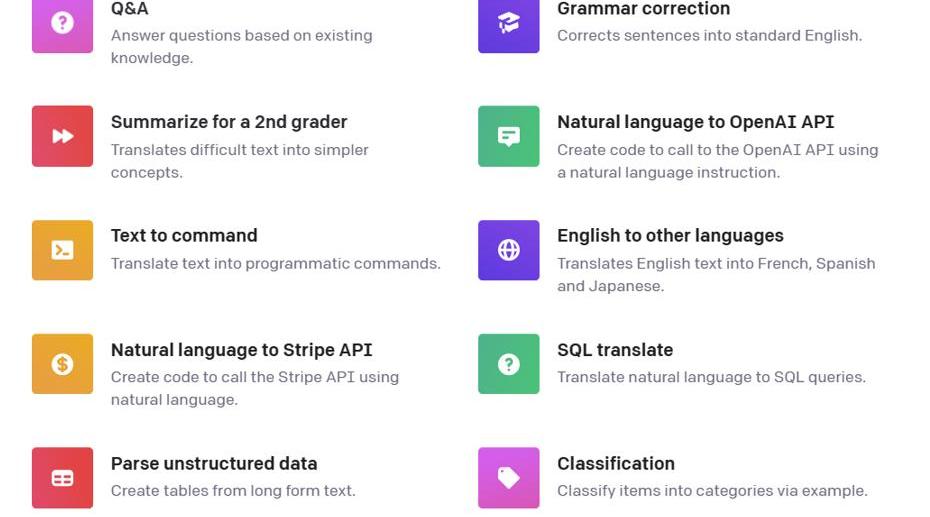

每种类别有很多具体的范例。如下图所示:

Figure2.PromptCategoriesExamplesbyOpenAI

除此以外,我们在此提出一些略微高级的用法。

高级分类

这是一个意图识别的例子,本质上也是分类任务,我们指定了类别,让ChatGPT判断用户的意图在这

Shiba Inu的L2网络Shibarium交易量突破1000万:金色财经报道,Shiba Inu的layer2网络Shibarium交易量突破1000万。在过去7天内,超过30亿个SHIB代币被烧毁。虽然主网尚未准备就绪,但该团队在几周前向公众开放了Puppynet测试网。据Puppyscan统计,截至发稿,Puppynet已完成1030万笔交易,处理了921214个区块。平均区块时间为5秒,而网络的钱包地址超过1500万。[2023/5/22 15:17:21]

Figure3.PromptExamples

实体识别与关系抽取

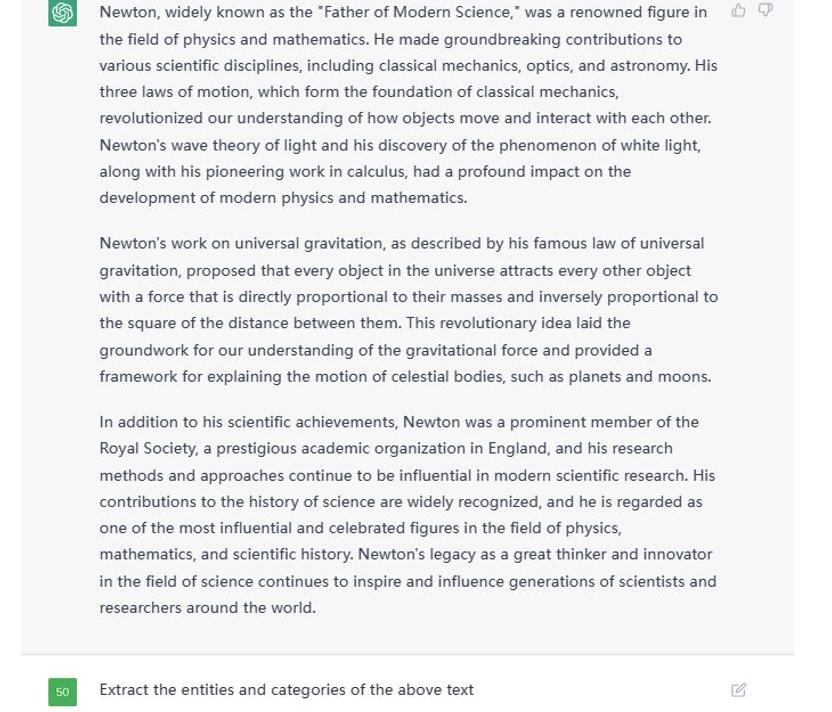

利用ChatGPT做实体识别与关系抽取轻而易举,例如给定一篇文本后,这么像它提问。

Figure4.ExampleTextGiventoChatGPT

这是部分结果截图:

Figure5.PartialOutputfromgivenTextonChatGPT

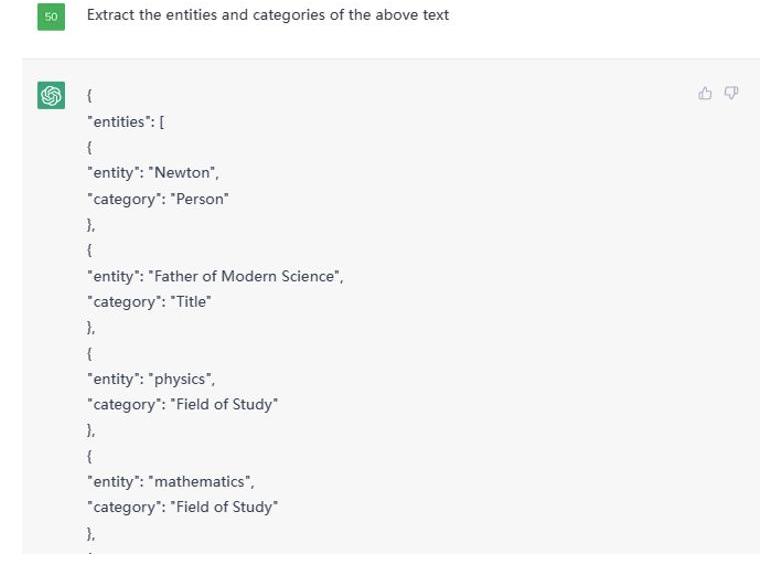

之后可以追问给他们的关系,例如:

今日恐慌与贪婪指数为53:金色财经报道,今日恐慌与贪婪指数为53(昨日为56),贪婪程度下降,等级仍为贪婪。注:恐慌指数阈值为0-100,包含指标:波动性(25%)+市场交易量(25%)+社交媒体热度(15%)+市场调查(15%)+比特币在整个市场中的比例(10%)+谷歌热词分析(10%)。[2023/4/24 14:23:01]

Figure6.AskingrelationshiponChatGPT

这样,一个大型的知识图谱便可轻松建立。

分析任务

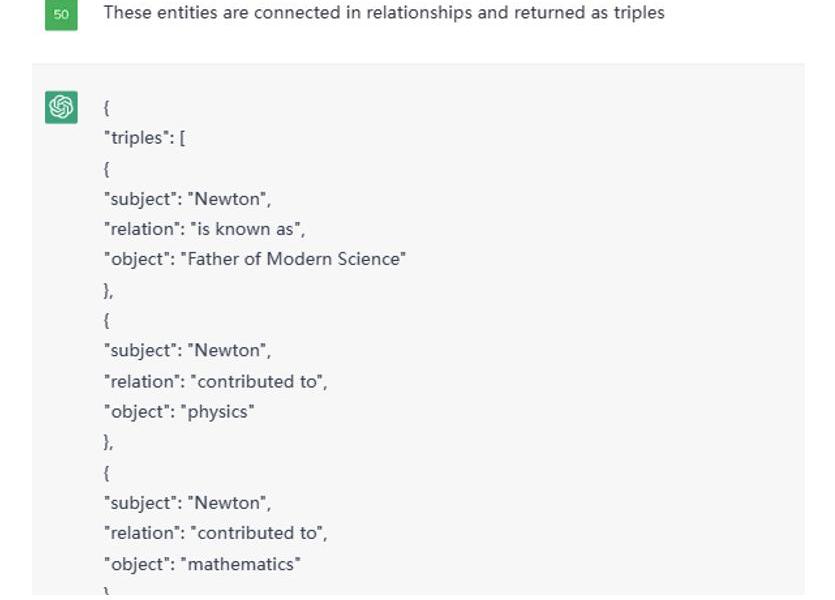

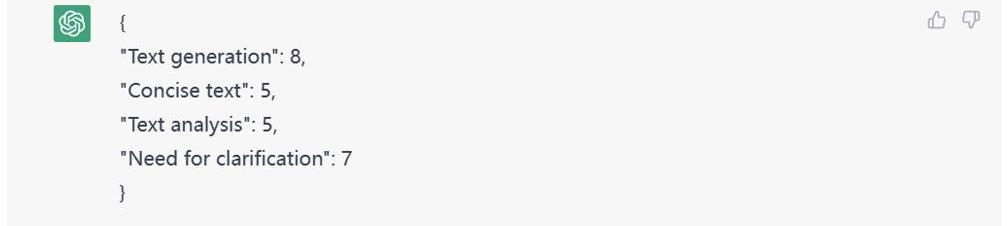

如下图所示,我对ChatGPT提出了分析我目前需求的问题。

Figure7.ResultforneedsrequestonChatGPT

甚至还能让它给定分数。

Figure8.Scoringtoevaluatetheidentifiedneeds

除此以外还有数不胜数的方式,在此不一一列举。

组合Agent

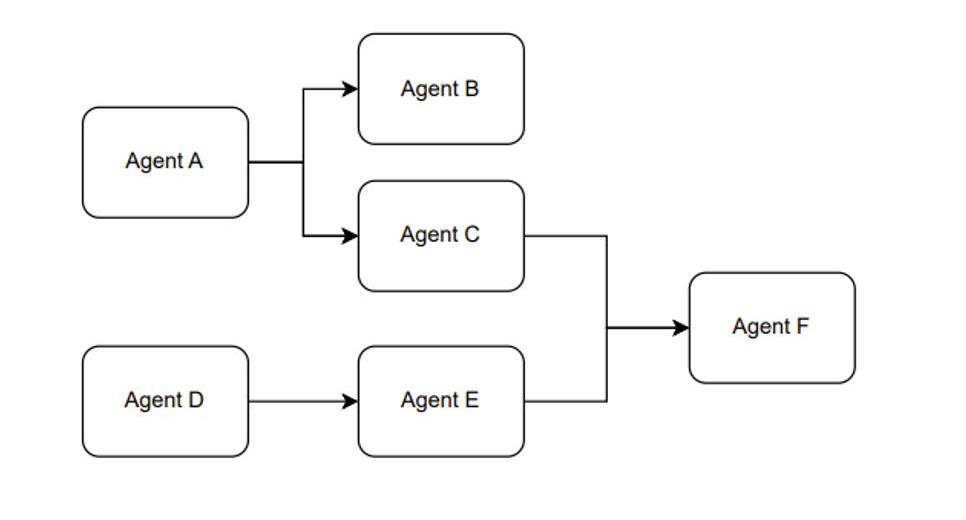

另外,我们在使用ChatGPT的API时,可以将不同的prompt模板产生多次调用产生组合使用的效果。我愿称这种使用方式叫做,组合Agent。例如Figure1展示的是一个大概的思路。

Pi Network:未授权任何加密货币交易所上线Pi代币:据官方推特,Pi Network发布最新声明,其Pi代币没有授权在任何加密货币交易所上线交易,目前交易所上线的Pi代币未经Pi Network同意、授权或参与,而且Pi Network本身没有涉及任何代币上线事宜并要求Pi矿工不要使用未经授权的交易所上线代币。

此外,Pi Network还澄清其代币目前仍处于“封闭网络”阶段,“封闭网络”时期将执行专注于构建生态系统效用和实现大规模KYC/迁移的战略,在此期间明确禁止在任何一家加密货币交易所交易,这意味着当前市场上交易的Pi代币违反了Pi Network的政策。Pi Network表示,他们已要求一些交易所下架Pi代币,但同时也在评估与第三方和交易所有关的其他行动。[2022/12/31 22:17:46]

Figure9.?TheParadigmoftheCombinationAgent

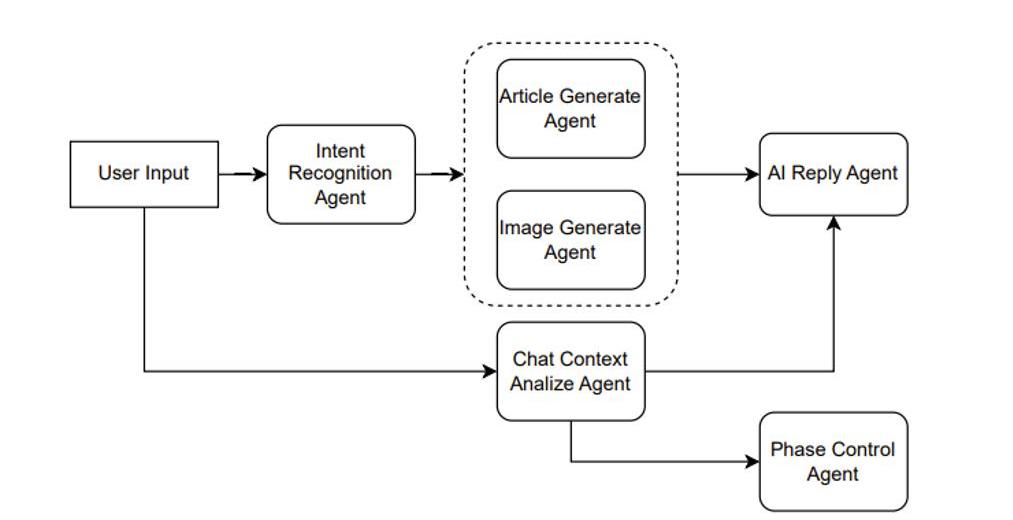

具体说来,例如是一个辅助创作文章的产品。则可以这么设计,如Figure10所示。

Figure10.Agentcombinationforassistingincreation

JPEX正式推出VISA借记卡:据官方消息,加密资产交易平台JPEX与网关Nuvei的 Simplex建立合作关系,旨在建立法币到加密支付入口解决方案。现已开通预购通道,预计2022年第四季度,推出并发放实体VISA借记卡。

据悉,JPEX是一家澳洲交易所,由来自日本、澳大利亚、美国等多个国家的开发团队共同维护。此外,JPEX也是Macarthur FC、Western Sydney Wanderers以及Western United等知名足球俱乐部的加密合作伙伴。[2022/9/1 13:01:31]

假设用户输入一个请求,说“帮我写一篇伦敦游记”,那么IntentRecognitionAgent首先做一个意图识别,意图识别也就是利用ChatGPT做一次分类任务。假设识别出用户的意图是文章生成,则接着调用ArticleGenerateAgent。

另一方面,用户当前的输入与历史的输入可以组成一个上下文,输入给ChatContextAnalyzeAgent。当前例子中,这个agent分析出的结果传入后面的AIReplyAgent和PhaseControlAgent的。

AIReplyAgent就是用来生成AI回复用户的语句,假设我们的产品前端并不只有一个文章,另一个敌方还有一个框用来显示AI引导用户创作文章的语句,则这个AIReplyAgent就是用来干这个事情。将上下文的分析与文章一同提交给ChatGPT,让其根据分析结果结合文章生成一个合适的回复。例如通过分析发现用户只是在通过聊天调整文章内容,而不知道AI还能控制文章的艺术意境,则可以回复用户你可以尝试着对我说“调整文章的艺术意境为非现实主义风格”。

PhaseControlAgent则是用来管理用户的阶段,对于ChatGPT而言也可以是一个分类任务,例如阶段分为等等。例如AI判断可以进行文章模板的制作了,前端可以产生几个模板选择的按钮。

使用不同的Agent来处理用户输入的不同任务,包括意图识别、ChatContext分析、AI回复生成和阶段控制,从而协同工作,为用户生成一篇伦敦游记的文章,提供不同方面的帮助和引导,例如调整文章的艺术意境、选择文章模板等。这样可以通过多个Agent的协作,使用户获得更加个性化和满意的文章生成体验。?

Prompt微调

LLM虽然很厉害,但离统治人类的AI还相差甚远。眼下有个最直观的痛点就是LLM的模型参数太多,基于LLM的模型微调变得成本巨大。例如GPT-3模型的参数量级达到了175Billion,只有行业大头才有这种财力可以微调LLM模型,对于小而精的公司而言该怎么办呢。无需担心,算法科学家们为我们创新了一个叫做prompttuning的概念。

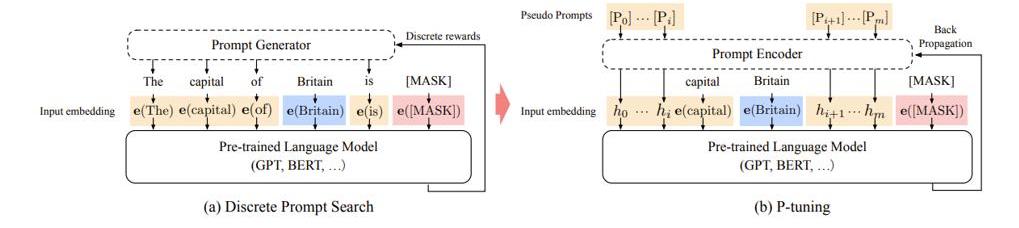

Prompttuning简单理解就是针对prompt进行微调操作,区别于传统的fine-tuning,优势在于更快捷,prompttuning仅需微调prompt相关的参数从而去逼近fine-tuning的效果。

Figure11.Promptlearning

什么是prompt相关的参数,如图所示,prompttuning是将prompt从一些的自然语言文本设定成了由数字组成的序列向量。本身AI也会将文本从预训练模型中提取向量从而进行后续的计算,只是在模型迭代过程中,这些向量并不会跟着迭代,因为这些向量于文本绑定住了。但是后来发现这些向量即便跟着迭代也无妨,虽然对于人类而言这些向量迭代更新后在物理世界已经找不到对应的自然语言文本可以表述出意思。但对于AI来讲,文本反而无意义,prompt向量随着训练会将prompt变得越来越符合业务场景。

假设一句prompt由20个单词组成,按照GPT3的设定每个单词映射的向量维度是12288,20个单词便是245760,理论上需要训练的参数只有245760个,相比175billion的量级,245760这个数字可以忽略不计,当然也会增加一些额外的辅助参数,但同样其数量也可忽略不计。

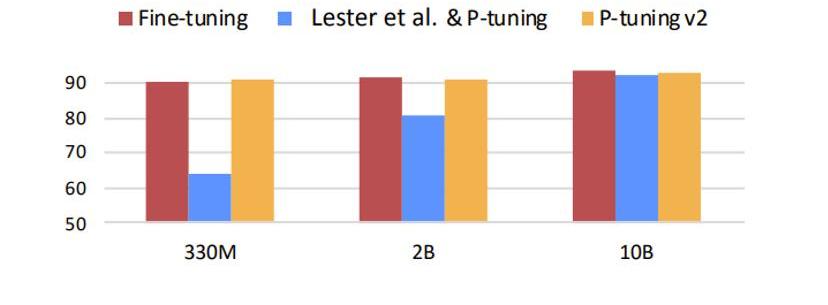

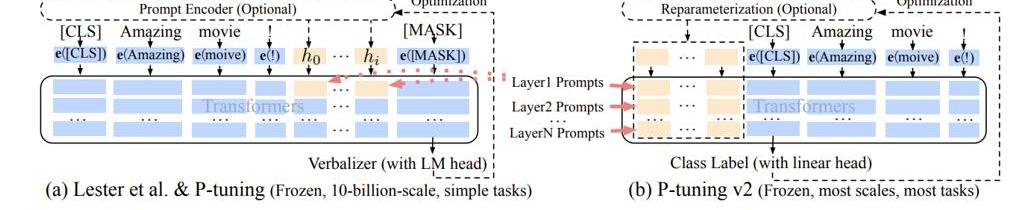

问题来了,这么少的参数真的能逼近?finetuning的效果吗,当然还是有一定的局限性。如下图所示,蓝色部分代表初版的prompttuning,可以发现prompttuning仅有在模型参数量级达到一定程度是才有效果。虽然这可以解决大多数的场景,但在某些具体垂直领域的应用场景下则未必有用。因为垂直领域的微调往往不需要综合的LLM预训练模型,仅需垂直领域的LLM模型即可,但是相对的,模型参数不会那么大。所以随着发展,改版后的prompttuning效果可以完全取代fine-tuning。下图中的黄色部分展示的就是prompttuningv2也就是第二版本的prompttuning的效果。

Figure12.Promptlearningparameters

V2的改进是将原本仅在最初层输入的连续prompt向量,改为在模型传递时每一个神经网络层前均输入连续prompt向量,如下图所示。

Figure13.Promptlearningv2

还是以GPT3模型为例,GPT3总从有96层网络,假设prompt由20个单词组成,每个单词映射的向量维度是12288,则所需要训练的参数量=96*20*12288=23592960。是175billion的万分之1.35。这个数字虽不足以忽略不计,但相对而言也非常小。

未来可能会有prompttuningv3,v4等问世,甚至我们可以自己加一些创新改进prompttuning,例如加入长短期记忆网络的设定。(因为原版的prompttuningv2就像是一个大型的RNN,我们可以像改进RNN一般去改进prompttuningv2)。总之就目前而言,prompttuning使得微调LLM变得可行,未来一定会有很多垂直领域的优秀模型诞生。

总结

LargeLanguageModels(LLMs)和Web3技术的整合为去中心化金融领域带来了巨大的创新和发展机遇。通过利用LLMs的能力,应用程序可以对大量不同数据源进行全面分析,生成实时的投资机会警报,并根据用户输入和先前的交互提供定制建议。LLMs与区块链技术的结合还使得智能合约的创建成为可能,这些合约可以自主地执行交易并理解自然语言输入,从而促进无缝和高效的用户体验。

这种先进技术的融合有能力彻底改变DeFi领域,并开辟出一条为投资者、交易者和参与去中心化生态系统的个体提供新型解决方案的道路。随着Web3技术的日益普及,LLMs创造复杂且可靠解决方案的潜力也在扩大,这些解决方案提高了去中心化应用程序的功能和可用性。总之,LLMs与Web3技术的整合为DeFi领域提供了强大的工具集,提供了有深度的分析、个性化的建议和自动化的交易执行,为该领域的创新和改革提供了广泛的可能性。

近期,Ordinals协议的火爆又激发起大家对比特币生态探索的兴趣。其实,在Ordinals协议之前,就有一个智能合约系统能够在比特币上发行代币和?NFT,它就是RGB.

1900/1/1 0:00:00引言尽管整体市场遇冷,但似乎Blur在NFTFi上向前跃进的脚步未曾放缓。根据其在5月2日所发布的推特动态,Blur正式从流动性聚合的直接交易层横跨到借贷市场,接连推出了P2P永续借贷Blend.

1900/1/1 0:00:00核心观点:CurveFinance近期除了crvUSD最重要的更新之一:TricryptoNewGeneration(TNG)或将促使Curve可以超越uniswap的交易量.

1900/1/1 0:00:00最近几周ScamSniffer陆续收到多个用户被搜索广告钓鱼的案例,他们都无一不例外错点了Google的搜索广告从而进入到恶意网站,并在使用中过程签署了恶意签名,最终导致钱包里的资产丢失.

1900/1/1 0:00:00DeFi正在从CeFi的学习中完善自己的金融工具,并蚕食CeFi的市场。今年3月,金融市场上最大的风险可能来自于美国银行业SilvergateBank、硅谷银行和SignatureBank的相继.

1900/1/1 0:00:00注:原文来自@0x_Todd发布长推。我最近一直想做一个关于如何获得秘密安全“助记词”方面的攻略,正好赶上前几天DoKwon的段子来了,我觉得有必要给大家分享一下.

1900/1/1 0:00:00